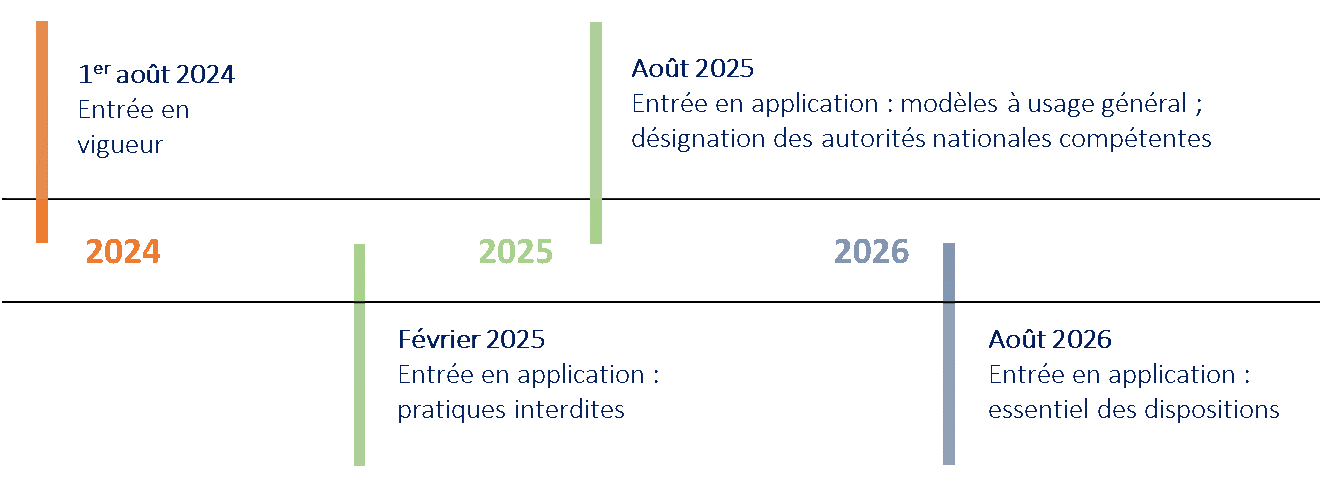

Le règlement européen sur l’IA est entré en vigueur le 1er août 2024. Bâti sur une logique de sécurité des produits (sur le modèle de législations existantes de l’Union (exemple : sécurité des jouets)), le texte entend promouvoir deux objectifs principaux :

- répondre aux risques pour la sécurité, la santé et les droits fondamentaux des citoyens ;

- créer un marché unique européen de l’« IA de confiance ».

Champ d’application

Le règlement sur l’IA s’applique aux systèmes d’IA, définis comme des systèmes automatisés, fonctionnant avec un certain degré d’autonomie, et qui génèrent des résultats (prédictions, recommandations, décisions, contenu) ayant la capacité d’influencer l’environnement physique ou virtuel. La définition vise à exclure les systèmes les plus simples. (La notion de système est notamment à distinguer de celle de modèle. Un système d’IA repose sur un modèle, mais constitue une notion plus large, incluant possiblement des interfaces homme-machine (permettant d’envoyer des instructions), ou encore des briques d’analyse des résultats (voire de conversion des résultats en décision). La distinction est particulièrement importante dans le domaine de l’IA générative).

D’un point de vue territorial, le règlement s’applique aux systèmes mis sur le marché, mis en service ou utilisés dans l’UE. Ainsi, le règlement s’applique aux fournisseurs et déployeurs européens ou non européens, dès lors qu’un système ou ses résultats sont disponibles pour des utilisateurs de l’UE.

Approche par les risques

Le règlement s’applique à tous les systèmes d’IA, mais de manière largement différenciée selon le niveau de risque estimé.

Périmètre des systèmes à haut risque

Les systèmes à haut risque sont principalement définis en fonction de leur finalité, au sein d’une liste de 8 domaines considérés comme sensibles (biométrie, emploi etc.) fixée par l’Annexe III du règlement. Dans le secteur financier, deux types de systèmes sont considérés comme à haut risque :

-

Banque : les systèmes d’IA destinés à l’évaluation de la solvabilité des personnes physiques ou à l’établissement de leur note de crédit (hors lutte contre la fraude)

-

Assurance : les systèmes d'IA à des fins d’évaluation des risques et de tarification pour les personnes physiques en matière d'assurance-vie et d’assurance santé.

Obligations applicables aux systèmes à haut risque

Les systèmes à haut risque doivent respecter un certain nombre d’exigences, notamment :

-

être dotés d’un système de gestion des risques, continu et itératif tout au long du cycle de vie ;

-

être développés sur la base de données de haute qualité ;

-

être accompagnés d’une documentation technique tenue à jour ;

-

être traçables et auditables, notamment via un mécanisme d’enregistrement automatique ;

-

présenter des garanties en termes de précision, de robustesse et de cyber-sécurité tout au long de leur cycle de vie.

Pour préciser le contenu de ces obligations, la Commission européenne a chargé les organismes européens de normalisation d’élaborer une dizaine de normes techniques harmonisées (standards). Une fois adoptées par la Commission, la conformité à ces normes vaudra conformité au règlement.

Rôle des différents opérateurs et obligations afférentes

D’après le règlement, les « opérateurs » sont les fournisseurs, les déployeurs, les importateurs, les distributeurs et les mandataires. Par simplicité, seul le rôle des deux premiers est décrit ici.

Les fournisseurs de systèmes d’IA à haut risque doivent réaliser une auto-évaluation de conformité des systèmes qu’ils mettent sur le marché ou mettent en service. Après avoir signé l’évaluation de conformité, les fournisseurs enregistrent leur système dans une base de données de l’UE.

Les déployeurs utilisent les systèmes d’IA conformément au mode d’emploi élaboré par le fournisseur, et assurent la supervision humaine du système. Avant toute utilisation du système, ils effectuent une analyse de son impact potentiel sur les droits fondamentaux.

Lorsque les fournisseurs ou déployeurs d’un système à haut risque sont des établissements financiers, ils bénéficient d’un régime spécifique, articulé avec la législation sectorielle. Certaines exigences du règlement sur l’IA sont ainsi intégrées dans les obligations existantes de contrôle interne ; d’autres sont présumées accomplies par le respect des règles sectorielles.

Le cas des modèles d’IA à usage général

L’IA à usage général (IA générative notamment) n’existait pas au moment où la Commission a proposé son projet de règlement. Mais, après la sortie de ChatGPT (novembre 2022), l’adoption très rapide de cette technologie a rendu nécessaire d’intégrer le sujet. Or ces modèles entrent mal dans la logique d’un texte construit sur la finalité des systèmes d’IA, puisqu’ils sont par définition capables d’accomplir une grande variété de tâches. Le règlement a donc introduit un encadrement spécifique :

-

tous les modèles d’IA à usage général sont soumis à des obligations de documentation et de partage d’information (sauf pour les modèles open source) ;

-

les modèles à risque systémique – définis par un seuil de puissance informatique – sont soumis à des obligations plus poussées d’évaluation et de transparence.

Les mesures en faveur de l’innovation : l’introduction de bacs à sables réglementaires (sandboxes)

Le règlement permet la mise en place de bacs à sables réglementaires dont l’objet est de permettre aux fournisseurs de tester certains systèmes d’IA sans devoir nécessairement respecter l’ensemble du cadre réglementaire normalement applicable.

Entrée en application du règlement

À l’exception de certaines dispositions (pratiques interdites, IA à usage général, gouvernance), le règlement sur l’IA entrera en application deux ans après son entrée en vigueur.

Règlement européen sur l’intelligence artificielle : comment l’ACPR se prépare-t-elle ?

L’intelligence artificielle connaît aujourd’hui un développement accéléré dans le secteur financier. Cette technologie constitue une innovation de rupture, porteuse d’opportunités mais aussi de risques, ce qui justifie l’adoption du règlement européen sur l’IA à l’été 2024. L’ACPR devrait être chargée de vérifier la bonne application de ce texte dans le secteur financier. Elle se prépare donc activement à cette nouvelle mission, tout en associant le marché à ses réflexions sur la mise en œuvre du règlement.

Mise à jour le 1 Juillet 2025