L’Autorité de contrôle prudentiel et de résolution, en partenariat avec Télécom Paris, a mené une étude sur les façons d’expliquer un conseil donné par un robot-conseiller (robo-advisor). L’enjeu était d’analyser les impacts des explications données par le robot-conseiller sur les clients, et les biais éventuels de ces outils faisant appel à l’IA.

Dans le domaine de l'assurance-vie, la réglementation financière exige qu’un conseil pour le choix d’un contrat soit justifié en montrant au client le lien entre les caractéristiques de la proposition financière et sa situation personnelle (Code des Assurances, Articles L. 521-4 et L. 522-5). L'objectif de cette réglementation est de protéger le client des conséquences négatives de choisir un investissement mal adapté, qu’il soit trop risqué ou trop peu performant par rapport à sa situation et à ses objectifs. Il s’agit de permettre au client de faire un choix éclairé.

L’essor des robot-conseillers pour la souscription facilite l'accès à l'investissement financier, dont l’assurance-vie. Ces outils proposent des conseils en ligne instantanés et automatisés, parfois basés sur l'Intelligence artificielle (IA) pour renforcer la personnalisation. Cependant la motivation du conseil à travers ces outils manque parfois de clarté ou bien reste trop générique, sans explications précises basées sur les caractéristiques propres au client. L'un des défis pour les robot-conseillers est de s’appuyer sur des outils permettant d'automatiser des explications qui doivent rester personnalisées en fonction de la situation de chaque client.

L’étude menée par Astrid Bertrand, doctorante de Télécom Paris, avec le Pôle Fintech-Innovation de l’ACPR, s’est penchée sur les questions suivantes : comment mettre en œuvre les explications motivant un conseil quand celui-ci est fourni de façon automatisée ? Quel est l’impact réel de ces explications sur l’éclairage apporté aux clients ?

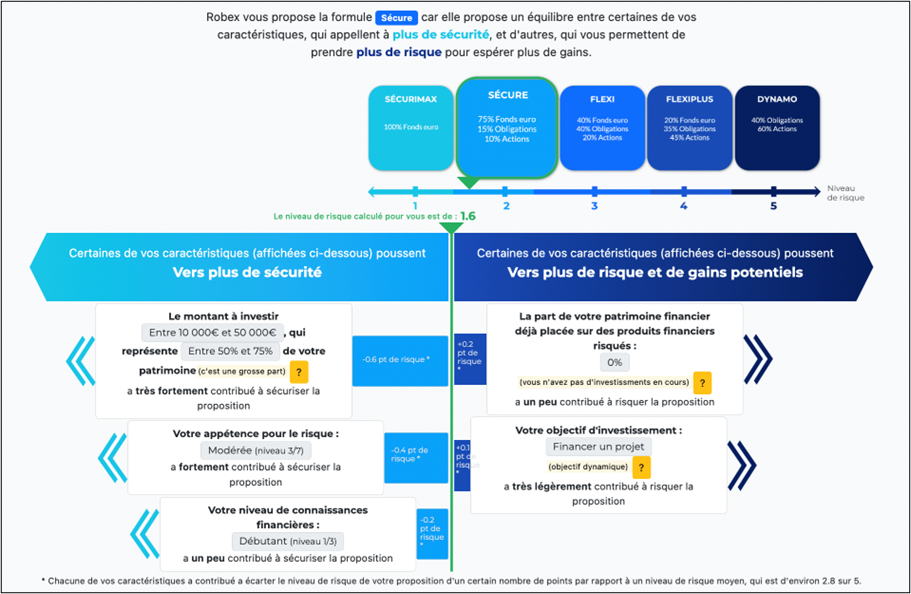

Pour répondre à ces questions, les auteurs ont développé leur propre robot-conseiller simplifié, en s’inspirant du modèle des robot-conseillers disponibles sur le marché. L’outil, dénommé Robex pour « robot-conseiller explicable », suivait les étapes classiques d’un parcours de souscription en ligne : d'abord le cadrage du besoin client via un questionnaire, puis le conseil pour un contrat d'assurance-vie. Robex proposait un conseil parmi cinq propositions fictives présentant différents degrés de risque. Il proposait également des explications automatisées pour les conseils donnés, mises en œuvre grâce à une technique « d’explicabilité » de l'intelligence artificielle. L’outil a été mis au point à partir d’entretiens avec des contrôleurs en assurance-vie de l’ACPR et perfectionné avec une série d’entretiens avec six experts en protection des consommateurs et cinq utilisateurs novices.

La seconde partie de l’étude visait à comprendre si les explications complémentaires fournies pour justifier le conseil donné, qui correspondent à une exigence légale, peuvent concrètement éclairer les utilisateurs, c’est-à-dire les aider à comprendre le conseil donné etsavoir s’il est préférable de le suivre ou non. Les auteurs ont mené une expérimentation quantitative avec 256 participants, pour la plupart novices en matière financière, recrutés via une plateforme collaborative. Les participants ont été répartis en plusieurs groupes, huit en tout, correspondant aux combinaisons entre deux versions de Robex et quatre formats différents d’explications. Une version de Robex donnait de bons conseils, l'algorithme de recommandation sous-jacent ayant été développé avec des experts pour trouver le bon niveau de risque financier pour un participant donné. L'autre version de Robex donnait des conseils mal adaptés aux besoins et à la situation du participant, c’est-à-dire soit trop risqués soit trop prudents. Ensuite, quatre types d’explications ont été testés : (1) une explication sous forme de graphique montrant le lien entre les caractéristiques du client et le niveau de risque proposé, (2) une explication adaptable, similaire à la première mais dans laquelle les participants pouvaient modifier certains de leur besoins (par exemple le montant à investir ou leur objectif financier) et voir l’impact du changement sur le conseil donné, (3) une explication textuelle donnant les mêmes informations mais sous forme de phrases présentées comme une conversation par message texte, (4) certains participants n'ont reçu aucune explication, constituant ainsi le groupe de contrôle.

Les résultats de l'étude montrent que les explications fournies sous forme de conversation augmentent à tort la confiance des utilisateurs dans les propositions incorrectes du robot-conseiller. Par ailleurs, les explications n'améliorent pas significativement la compréhension de la proposition par les utilisateurs, ni leur capacité à suivre ou non le conseil donné, selon s'il est correct ou non. Enfin, les informations factuelles sur les propositions incorrectes sont moins bien comprises par les participants, et les personnes qui ont reçu un niveau d’éducation plus faible comprennent moins bien une proposition incorrecte mais ont plus tendance à l’accepter quand même.

L'étude a été publiée dans les actes de la conférence internationale "Fairness, Accountability and Transparency" qui s'est tenue en juin 2023. L'article (en anglais) est consultable librement.

Updated on the 4th of September 2025